Le succès de votre site internet repose en grande partie sur son positionnement sur les moteurs de recherche. Pour qu’une page web s’affiche sur la SERP (Search Engine Result Page), elle doit être analysée par un robot de Google. Ceux-ci passent en revue l’intégralité de votre plateforme, allant du contenu aux algorithmes afin de mieux le classer dans les pages de résultats. Dans ce cas, on parle de « phase de crawl » ou de « processus d’exploration ». Cela fait partie des tendances SEO pour booster sa visibilité.

Notion clé en SEO, le budget crawl correspond au nombre de pages de votre site ou URLs que les « Googlebots » explorent par jour. D’une manière générale, votre budget d’exploitation dépend de la taille de votre site et du nombre de liens qui pointent vers celui-ci. Comment optimiser votre budget crawl ? Voici tout ce que vous devez savoir.

Pourquoi optimiser le budget crawl de votre site web ?

Il convient de souligner que le crawl n’est pas un signal de classement.

Cela signifie que l’exploration n’a pas d’impact direct sur la position d’une page dans les résultats de recherche naturels.

Mais les budgets de crawl sont importants pour le SEO car :

- Si une page n’est pas indexée par les moteurs de recherche, elle n’apparaîtra pour AUCUNE recherche

- Si un site Web a beaucoup de pages, Google peut ne pas toutes les indexer (c’est pourquoi l’optimisation du budget de crawl est nécessaire – plus à ce sujet ci-dessous)

- Les modifications apportées à une page peuvent ne pas apparaître aussi rapidement qu’elles le devraient dans les résultats de recherche.

Néanmoins, comme vous le lirez ci-dessous, la façon d’optimiser votre budget de crawl consiste à suivre les meilleures pratiques de référencement , ce qui a également un effet positif sur votre classement.

Combien d’URL de votre site les Googlebots explorent-ils par jour ?

Pour éviter le gaspillage de votre budget crawl, vous devez connaître le nombre d’URL de votre site exploré par les bots chaque jour. En ce sens, l’analyse des fichiers de logs se présente comme la solution la plus adaptée. Cela permet de définir l’image que renvoie votre site aux moteurs de recherche. Vous pourrez ainsi collecter les informations détaillées sur la fréquence de crawl et les parties du site les plus concernées. Pensez à l’utilisation d’outils performants comme la Search Console.

Les conseils à suivre pour optimiser le budget de crawl

Voici quelques éléments à prendre en compte pour optimiser votre budget crawl.

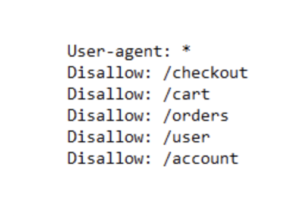

Utiliser correctement le fichier robots.txt

Pensez à bloquer certains paramètres d’URL ou encore des répertoires qui n’apportent aucune valeur ajoutée à votre site web. En effet, l’existence de pages inutiles fait partie des principaux facteurs de gaspillage du budget crawl. Si vous n’êtes pas familier, les fichiers robots.txt se trouvent à la racine des sites Web et ressemblent à ceci :

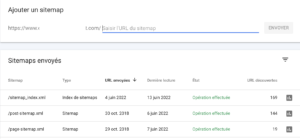

Optimiser vos sitemaps en empêchant google d’explorer vos URL non canoniques

Toutes les URL incluses dans les sitemaps XML doivent être destinées aux pages indexables. Surtout avec les grands sites Web, les moteurs de recherche s’appuient fortement sur les sitemaps XML pour trouver toutes vos pages. Si vos sitemaps XML sont encombrés de pages qui, par exemple, n’existent plus ou sont redirigées, vous gaspillez votre budget de crawl. Vérifiez régulièrement votre plan de site XML pour les URL non indexables qui n’y appartiennent pas. Vérifiez également le contraire : recherchez les pages qui sont incorrectement exclues du sitemap XML. Le sitemap XML est un excellent moyen d’aider les moteurs de recherche à dépenser judicieusement leur budget d’exploration.

Une bonne pratique pour l’optimisation du budget d’exploration consiste à diviser vos sitemaps XML en plus petits sitemaps. Vous pouvez par exemple créer des sitemaps XML pour chacune des sections de votre site Web. Si vous l’avez fait, vous pouvez rapidement déterminer s’il y a des problèmes dans certaines sections de votre site Web.

Supposons que votre sitemap XML pour la section A contienne 500 liens et que 480 soient indexés : alors vous vous en sortez plutôt bien. Mais si votre sitemap XML pour la section B contient 500 liens et que seuls 120 sont indexés, c’est quelque chose à examiner. Vous avez peut-être inclus de nombreuses URL non indexables dans le sitemap XML pour la section B.

Optimiser la vitesse de chargement

La vitesse de chargement du site est un paramètre important à prendre en compte pour l’optimisation du budget d’exploration. C’est pourquoi il est important d’améliorer l’hébergeur et le serveur. Vous devez également optimiser les ressources utilisées pour le chargement de chaque page. Un crawler ne perdra pas de temps à explorer un site lent et peu fluide.

Optimiser le maillage interne

La qualité du maillage interne est un aspect important pour les robots. Ainsi, il est important que de mettre un maximum de liens internes dans les pages stratégies que la page d’accueil. Comment améliorer son netlinking ? Faites appel à un expert. Celui-ci peut procéder à un audit profil de liens pour des backlinks efficaces en référencement.

Limiter le contenu dupliqué

Il se peut que certaines pages de votre site contiennent du contenu dupliqué (interne ou externe). Dans ce cas, les Googlebots risquent de passer plusieurs fois sur le même contenu. Votre budget crawl risque alors de se consumer tout seul. Veillez à ce que le contenu de votre site soit unique et authentique pour éviter le gaspillage du budget d’exploitation.

Mettre régulièrement à jour le contenu existant

Une mise à jour régulière de votre site vous permettra d’améliorer les performances de chaque page. Il est important que celles-ci soient conformes aux nouvelles exigences de Google. Cela peut influencer positivement la gestion de votre budget crawl. Il est important que les robots de Google trouvent les nouvelles pages web à indexer lorsqu’ils se rendent sur votre site.

- Si vous souhaitez renforcer l’efficacité de vos efforts d’un point de vue SEO et augmenter le trafic de votre moteur de recherche, c’est simple : mettez à jour votre ancien contenu et améliorez votre score de fraîcheur.

- Vous obtenez un pic de trafic lorsque vous dites à Google que votre contenu est nouveau. Cela rendra la petite quantité de travail qu’il faut en valoir la peine.

- Si Google remarque un changement dans votre contenu, votre site sera probablement réexploré. S’il trouve des améliorations dans votre contenu, Googlebot peut vous accorder un budget plus élevé.

Simplifier l’architecture du site

Il est conseillé d’adopter une structure à la fois simple, claire et compréhensible pour les visiteurs de votre site :

- Niveau 1 : page d’accueil

- Niveau 2 : pages de catégories

- Niveau 3 : pages de contenu et fiches produits

Vos pages doivent être axées autour d’une thématique commune. Elles doivent également être connectées par des liens internes.

Voici quelques-unes des meilleures pratiques concernant la structure du site :

- Suivez la fameuse règle des trois clics, qui stipule que tout utilisateur doit pouvoir passer de n’importe quelle page de votre site à une autre en trois clics maximum.

- Vous pouvez utiliser Screaming Frog SEO Spider pour analyser la structure et la profondeur d’exploration de votre site. L’outil vous montrera également toutes les pages orphelines.

- Évitez les pages « sans issue » ou orphelines qui sont les pages qui ne contiennent aucun lien interne ou externe.

- Utilisez des URL canoniques dans le sitemap XML. Même si cela n’influence pas directement le budget de crawl, cela peut aider Google à comprendre quelles pages il doit explorer et indexer.

A qui faire appel ?

Ce genre de tâche peut être assez complexe pour un novice dans l’optimisation seo. Pourquoi ne pas choisir une agence de référencement ? Par la même occasion notre consultant SEO vous proposera les conseils indispensables pour concilier webdesign et SEO.

Articles blog

Restez à la page et profitez de nos conseils, meilleures pratiques SEO et astuces.

Optimiser votre visibilité sur Perplexity : être cité et bien référencé

Prêt à booster votre présence sur Perplexity AI? Ce guide complet vous offre des stratégies éprouvées pour améliorer votre visibilité et engagement. Découvrez comment structurer votre contenu, gagner en autorité et optimiser techniquement votre site pour être cité. Lisez dès maintenant et transformez votre visibilité digitale !

Bien se Classer dans les Réponses de Google Gemini : Le Guide Complet pour Dominer l'IA Search

L’ère du SEO classique touche à ses limites. Découvrez comment optimiser vos contenus pour Google Gemini et dominer la recherche générative. Ne subissez pas l’IA : maîtrisez-la. Lisez notre guide stratégique dès maintenant.

5 conseils pour créer une page FAQ conviviale pour le référencement

Vous sous-estimez encore la puissance SEO d’une page FAQ ? Découvrez comment transformer une simple liste de questions en véritable aimant à trafic et à positions Google. Gagnez en visibilité, en conversions et en pertinence grâce à 5 conseils concrets et actionnables. Ne passez pas à côté.

Retour

Retour Partager

Partager

Laisser un commentaire